De nombreux artistes s'insurgent face à l'utilisation de leurs œuvres par certaines entreprises pour entraîner leur intelligence artificielle génératrice d'images. EEn début d'année, ils ont initié des procès en justice pour faire valoir leurs droits. À présent, ils explorent également des solutions technologiques pour riposter contre ces pratiques d'entreprises. Nightshade pourrait être l'outil qui les aidera dans cette bataille.

Nightshade s'attaque à l'algorithme de l'IA

Les générateurs d'images s'entraînent sur d'immenses bases de données comprenant des millions d'images. Certains outils tels que Stable Diffusion et À mi-parcours utilisez des données, dont une grande partie est soumise à des licences. Selon les artistes, cela constitue une violation du droit d'auteur. Ils dénoncent l'exploitation abusive de leurs créations par certaines entreprises technologiques.

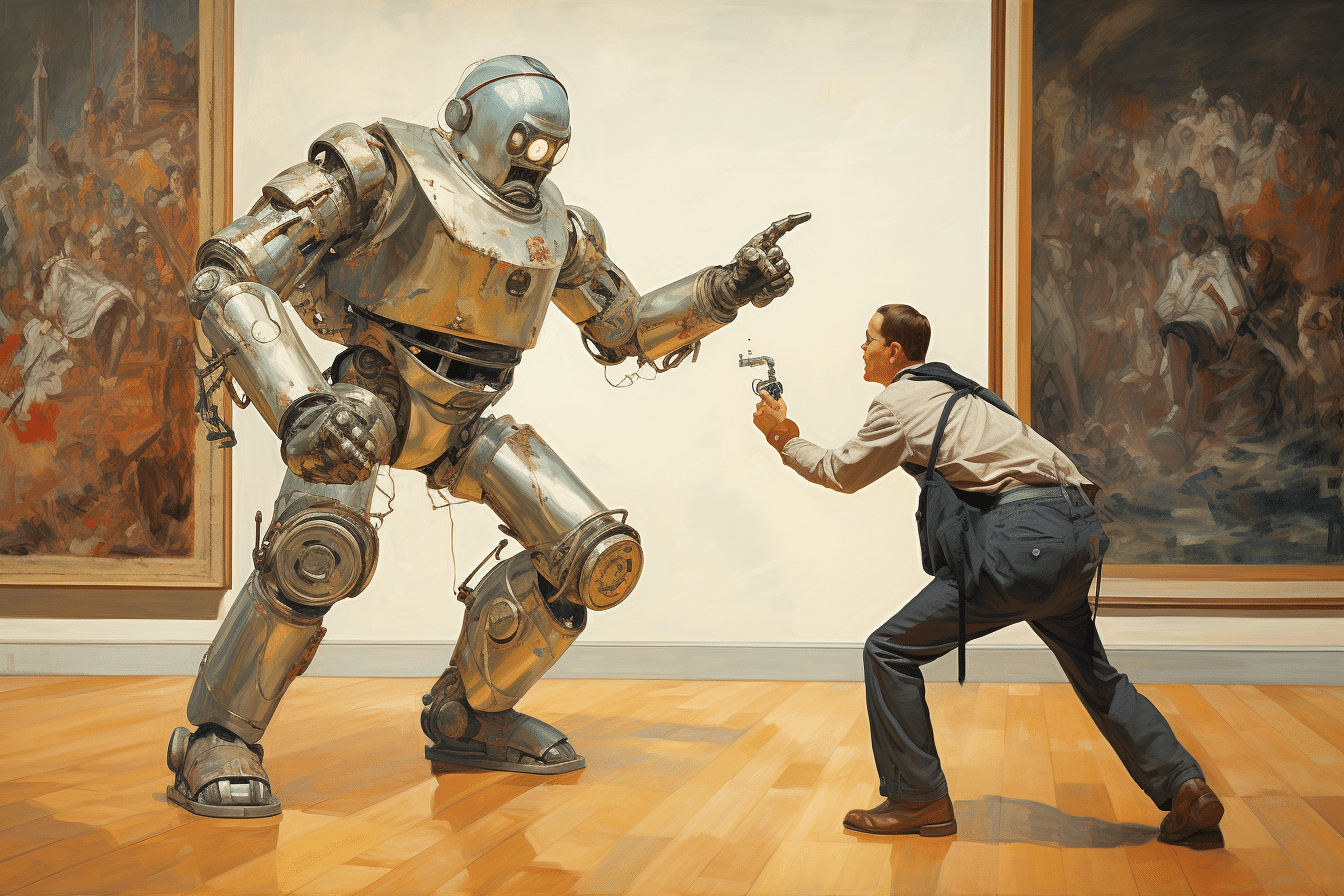

C'est dans ce contexte que des développeurs de l'Université de Chicago ont développé Nightshade. Cet outil altère de manière imperceptible pour l'œil humain certains pixels des images. Lorsque les IA assimilent ces images empoisonnées ou altérées, cela perturber leur apprentissage. Cela conduit à des classements incorrects des images. Par conséquent, les utilisateurs obtiendront des résultats aberrants qui ne correspondent pas à leur invite.

Par exemple, si l'IA est sollicitée pour générer un ballon rouge sur un ciel bleu, elle produit un œuf à la place. Si de telles situations se produisent, cela indique que l'ensemble de données de l'outil a été empoisonné. Nightshade peut également induire les algorithmes à générer des images avec des caractéristiques étranges, comme des chiens qui possèdent six pattes.

La dernière ligne de défense des artistes

Pour générer des images à la hauteur des attentes des utilisateurs, l'IA doit utiliser des données de qualité. Inversement, à mesure qu'elle assimile davantage d'images empoisonnées, elle ne fonctionnera plus correctement. Cet impact se reflétera également sur les résultats des invite textuelles associées.

Dans leur publication sur le serveur de pré-impression arXiv, les concepteurs de Nightshade annoncent qu'il suffit d'un nombre limité d'images empoisonnées pour déstabiliser les capacités globales de génération de l'intelligence artificielle. Incapable de produire des images cohérentes, l'IA devient ainsi inutilisable. Et les artistes en colère auront leur revanche !

Nightshade se veut donc une solution de dernier recours face aux sociétés qui persistent à entraîner leurs IA avec du contenu protégé. L'objectif est de les sensibiliser sur l'importance du respect des droits d'auteur.

Les créateurs de Nightshade sont cependant conscients des risques d'utilisation malveillante par certains utilisateurs. En soulignant en masse des images altérées, ces derniers pourraient entraîner des dysfonctionnements graves des IAconduisant à la production de contenus inadaptés.

La bataille pour les données d'entraînement : Nightshade est une méthode « d'empoisonnement » des images de sorte que lorsqu'elles sont utilisées par l'IA à des fins d'entraînement, cela compromet systématiquement la capacité de l'IA à produire les images correctes à l'avenir.

(Cela ne fonctionnera pas pour les LLM basés sur du texte) https://t.co/40W3bOsg2X pic.twitter.com/DrHRsTOl4r

– Ethan Mollick (@emollick) 25 octobre 2023

Quelles stratégies en réponse à Nightshade ?

De leur côté, les générateurs d'images ne resteront probablement pas les bas croisés. Ils réagiront à Nightshade. Pour cela, ils pourraient être amenés à ajuster leurs algorithmes pour contrer l’empoisonnement de cet outil.

Ils continueront également d'améliorer leurs modèles par la classification des images par les humainscomme l'a fait récemment Midjourney avant le lancement de sa version 6. Enfin, pour éviter que Nightshade nuise au bon fonctionnement de leur outil, les entreprises d'IA pourraient également être incitées à accorder plus d'attention à la provenance des données utilisées pour la formation de leur modèle.