La liste des IA génératives vient d'accueillir un nouveau membre. De OpenAI un À mi-parcoursc'est maintenant au tour de Google de se lancer dans la fête avec le lancement de Gemma, sa nouvelle intelligence artificielle officialisée le 21 février 2024.

Le projet Gemma de Google s'inscrit alors dans la lignée des travaux menés par Esprit profond et diverses équipes de Google sur les modèles de langage conversationnel. Son nom est inspiré du mot latin Gémeaux qui signifie pierre précieuse. En étant un modèle open source, Gemma se démarque par sa totale transparence. L'intégralité de son architecture, de sa méthodologie d'entraînement, de ses poids et ses paramètres sont d'ailleurs rendus publics sous des licences libres d'accès. Les chercheurs et développeurs peuvent ainsi librement explorer, comprendre, réutiliser et même adapter Gemma, proposé en deux architectures (on en parlera plus tard), pour répondre à leurs besoins spécifiques.

Compacte, accessible gratuitement, adaptable à chaque tâche, vraiment la perle rare comme son nom l'indique

Conçue de manière compacte, Gemma se décline sous deux versions. Si le modèle 2B est à 2 milliards de paramètres, le 7B en est à 7. Si on les compare avec les autres modèles, ils sont beaucoup plus petits, mais ont une performance élevée. En d'autres termes, les modèles 2B et 7B nécessitent moins de puissance de calcul. Mais ils sont beaucoup plus rapides que les autres modèles d'IA.

Un autre atout majeur de Gemma par rapport aux autres modèles, il est accessible gratuitement. Les développeurs pourront ainsi modifier et améliorer son code source. Côté utilisation, ce nouveau modèle d'IA de Google s'adapte parfaitement à n'importe quelle tâche. Dont la génération de réponses à chaque question posée, le résumé d'un texte, ou encore la création de synthèse de contenu et de campagnes marketing par mail.

Gemma : deux modèles bien distincts dédiés aux particuliers et aux entreprises

Chaque configuration, notamment le modèle Gemma 2B et le modèle 7B, offre des éléments fondamentaux d'intelligence artificielle polyvalents. Ils adapter alors aussi bien aux besoins personnels qu'aux solutions d'entreprise.

Le modèle Gemma de Google bénéficie de la même technique derrière Gemini, leur système d'IA conversationnelle le plus abouti. En tirant partie de cette base technologique de pointe, les versions 2B et 7B de Gemma ont montré des performances inégalées par rapport à d'autres modèles open source. Leurs capacités de premier plan dans leurs catégories respectives ont d'ailleurs été saluées.

Malgré des dimensions plus réduites que certains modèles, Gemma s'est illustrée sur des critères clés tout en respectant des normes strictes en termes de fiabilité et de sécurité des générations de texte.

D'après les données publiées par Google, la version 7B de Gemma surpasse largement le modèle Llama 2 7B de Méta sur plusieurs points : raisonnement, mathématiques et rédaction de code. À titre d'exemple, elle obtient des scores assez élevés sur les benchmarks BBH, GSM8K et MATH 4-shot. Quitte à dire que Gemma 7B se montre aussi bien plus performante pour générer du code Python.

Un ensemble d'outils pour une meilleure adaptabilité, merci Gemma !

D'après les informations fournies par Google, Gemma se démarque de la concurrence par sa grande flexibilité et son écosystème ouvert. Il permet tout d'abord d'affiner facilement ses modèles sur des données spécifiques. Ce qui permet une meilleure personnalisation pour répondre aux besoins uniques de chaque cas d'utilisation. Notamment, comme mentionné plus haut, la génération augmentée ou la synthèse de texte.

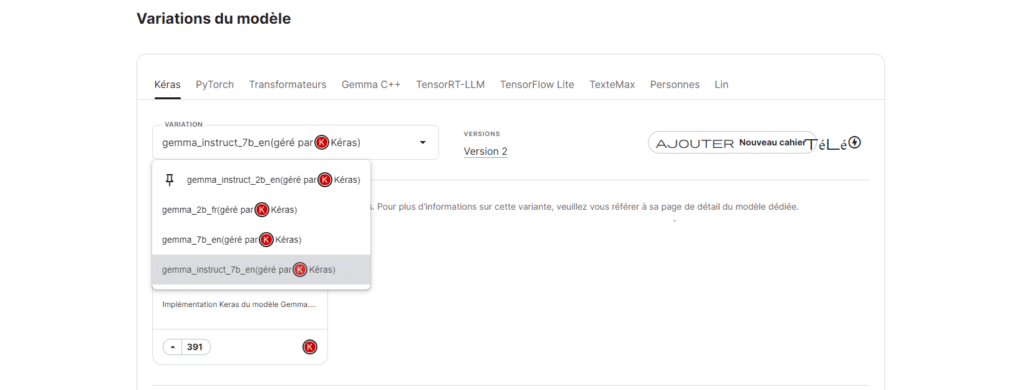

Gemma prend également en charge une large palette d'outils et frameworks populaires tels que Keras, JAX, Transformers ou PyTorch natif. Cette capacité offre la possibilité de faciliter son intégration dans différents environnements. Mais Google ne s'est pas limité à ces éléments ! Ils ont alors décidé de lancer une version compatible avec tout type d'appareils. Ne les appareils mobiles, les PC, l'IoT, ou encore le cloud.

En parlant de cloud, Gemma bénéficie également d'une intégration privilégiée avec les services cloud et outils MLOps de Google comme Vertex AI. Cela facilite les phases de personnalisation, d'optimisation, de déploiement et de gestion des modèles sur différentes infrastructures CPU/GPU/TPU.

Sur quels types de données Gemma a-t-il été formé ?

Les modèles Gemma 7B et 2B sont, selon Google, une version améliorée de Gemini. Ils ont été entraînés sur d'immenses corpus de données privilégiant le contenu web, les mathématiques et la programmation informatique. Mais contrairement à Gémeaux, Gemma n'est pas conçu pour le multilingue ou le multimodal. Il se concentre plutôt sur un traitement approfondi du texte anglais.

Sa méthodologie de formation, dont l'apprentissage supervisé et l'apprentissage par renforcement à partir de feedbacks vise cependant à optimiser la compréhension et la génération nuancée de textes en anglais. Gemma bénéficie également d'innovations comme un vocabulaire étendu et une nouvelle approche de tokenisation améliore le traitement des différents types de données.

Cette spécialisation dans le traitement du langage naturel anglaisen particulier sur des domaines techniques comme l'informatique et les mathématiques, souligne le potentiel de Gemma pour des applications de niche très avancées.

Dans une démarche visant à promouvoir l'accessibilité et l'innovation, Google rend disponible gratuitement son modèle Gemma à l'ensemble de la communauté. En tant que chercheurs et développeurs, vous pouvez désormais accédez librement à ces modèles de langage conversationnel sur des plateformes telles que Kaggle et Google Colab.

Par ailleurs, des crédits cloud exclusifs sont offerts aux nouveaux utilisateurs de Google Cloud pour leur permettre d'expérimenter Gemma. Les équipes académiques ont même la possibilité de solliciter jusqu'à 500 000 $ de crédits dédiés afin d'accélérer le développement de leurs projets de recherche autour de cette technologie.

Configuration requise et initialisation de Gemma en local

Pour tirer parti des meilleures performances du Gemma 2B, vous aurez besoin de certaines spécifications matérielles. Tout d'abord, un processeur Intel i5 multicœur ou supérieur est recommandé. 16 Go de RAM sont également nécessaires pour l'architecture 2B, contre 32 Go pour Gemma 7B. Vous devrez par ailleurs disposer d'au moins 50 Go d'espace libre sur un SSD.

Si vous utilisez macOS, assurez-vous qu'il est à jour parce que Gemma nécessite Monterey ou une version ultérieure. Sinon, la configuration Ollama vous permettra également d'initialiser et d'interagir localement avec les modèles Gemma.

Pour initialiser une instance Gemma locale, suivez ces étapes. Tout d'abord, lancez le modèle Gemma souhaité via Ollama CLI. Pour le modèle Gemma 2B (plus petit), exécutez « ollama court gemma:2b ». Pour Gemma 7B (plus grand), exécutez « ollama run gemma:7b ».

Deuxièmement, lors de la première exécution, les ressources du modèle sélectionné seront téléchargées, ce qui peut prendre un certain temps. Une fois le téléchargement terminé, Gemma s'initialise et sera prête à être utilisée.

Gemma dans les entreprises, les différents cas d'utilisation

Pour les entreprises, Gemma est la réponse qui pourrait leur fournir des solutions open source à leurs besoins spécifiques. De la création d'un chatbot au développement d'applications multimodales, en passant par le traitement du NLP et l'analyse des données, Gemma offre une multitude de réponses.

La version compacte et optimisée de Gemma 2B par exemple, est idéal pour développer des agents conversationnels et des assistants virtuels. C'est-à-dire des solutions IA déployables sur appareils mobiles ou systèmes embarqués. Pour les entreprises, cela permet d'améliorer leurs services clients, l'assistance et l'engagement utilisateurs sans avoir à déployer des ressources informatiques lourdes.

Quant au modèle 7B de Gemma, il est plus imposant, mais est doté d'une capacité étendue pour des tâches plus complexes. Il se prête idéalement à l'analyse approfondie de vastes ensembles de données et de documents. On parle alors d'un outil performant et efficace dans l'extraction d'informations. Mais aussi dans les procédures de discernement des tendances et prise de décision stratégique.

En résumé, Gemma est une victoire pour Google. Mais au fur et à mesure où l'intelligence artificielle évolue, il y aura sûrement d'autres modèles plus puissants et plus performants. OpenAI par exemple, un lancé récemment Sora, fils IA génératrice de texte en vidéo. Il y a également la sortie récente de la version 1.0 d'Ideogram qui, selon ses développeurs, est plus puissant que Midjourney et DALL-E.

- Partager l'article :

Notre blog est alimenté par les lecteurs. Lorsque vous achetez via des liens sur notre site, nous pouvons percevoir une commission d'affiliation.